Hadoop实时计算工程师简历模板

熊猫简历Hadoop实时计算工程师简历模板,支持自定义板块、自定义颜色、AI润色、技能条、荣誉墙、一键更换模板,专业AI辅助一键优化Hadoop实时计算工程师简历内容,仅需5分钟即可拥有一份精美的Hadoop实时计算工程师简历模板,助力你获得「高薪职位」。

云端操作,实时保存

排版格式完整

打印效果最好

操作简单、制作快速,AI 智能优化

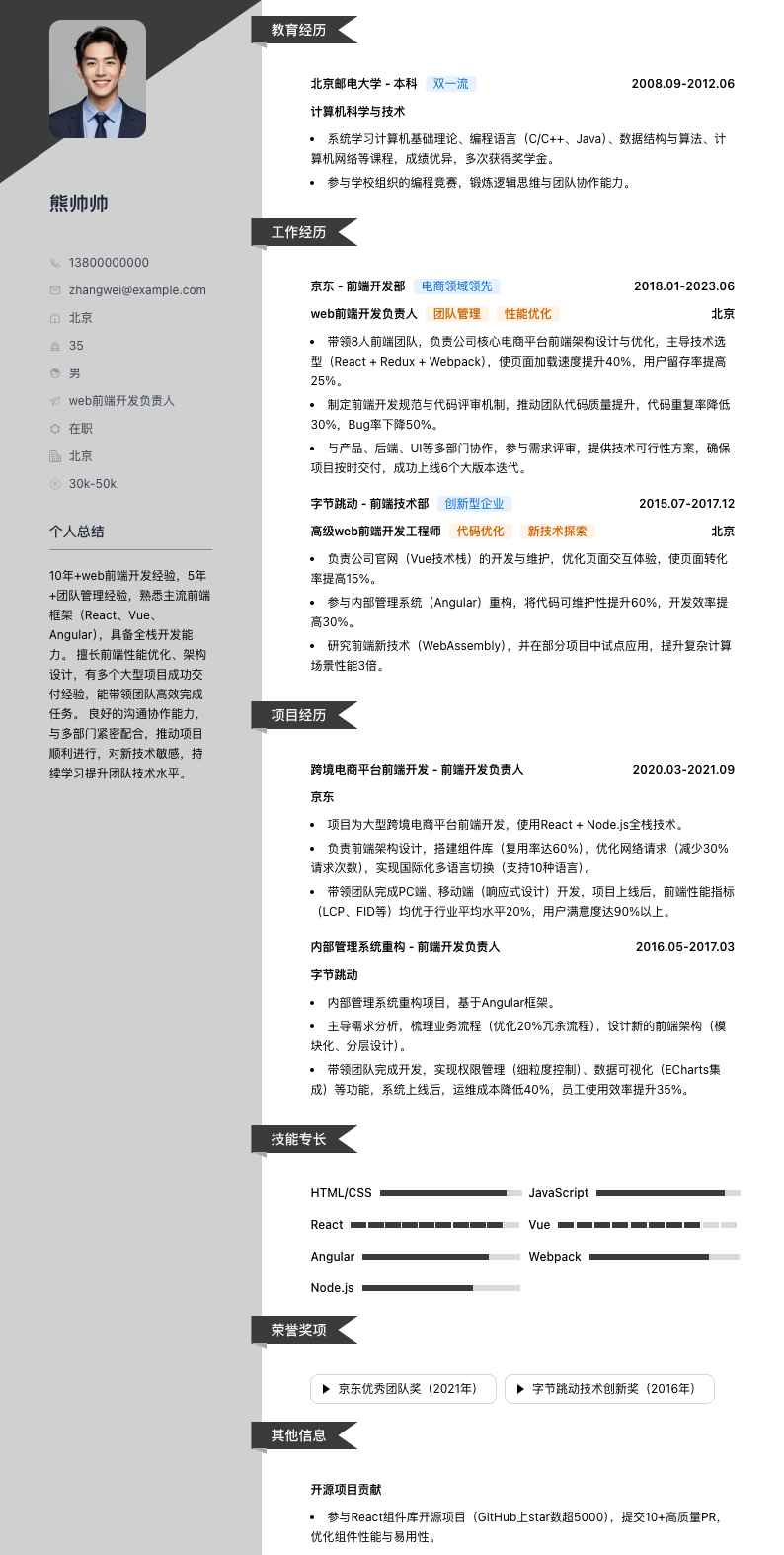

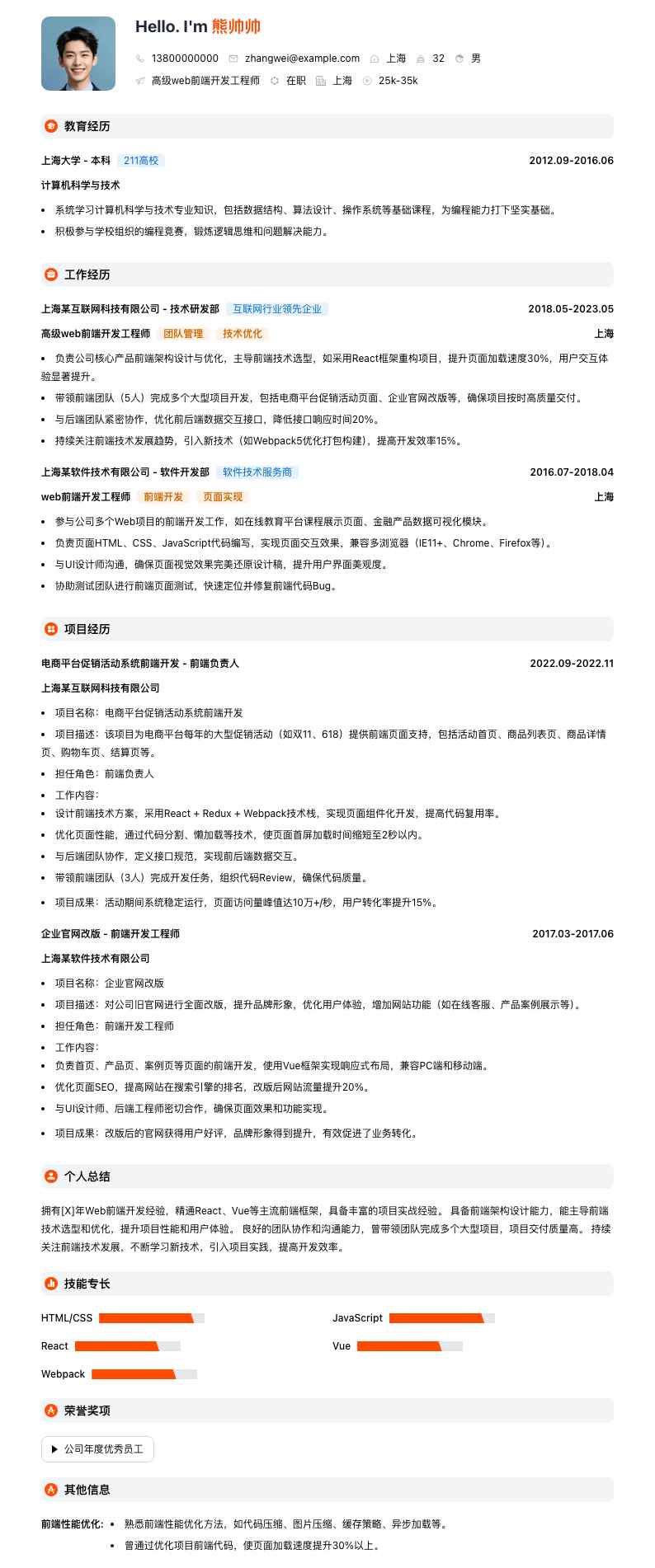

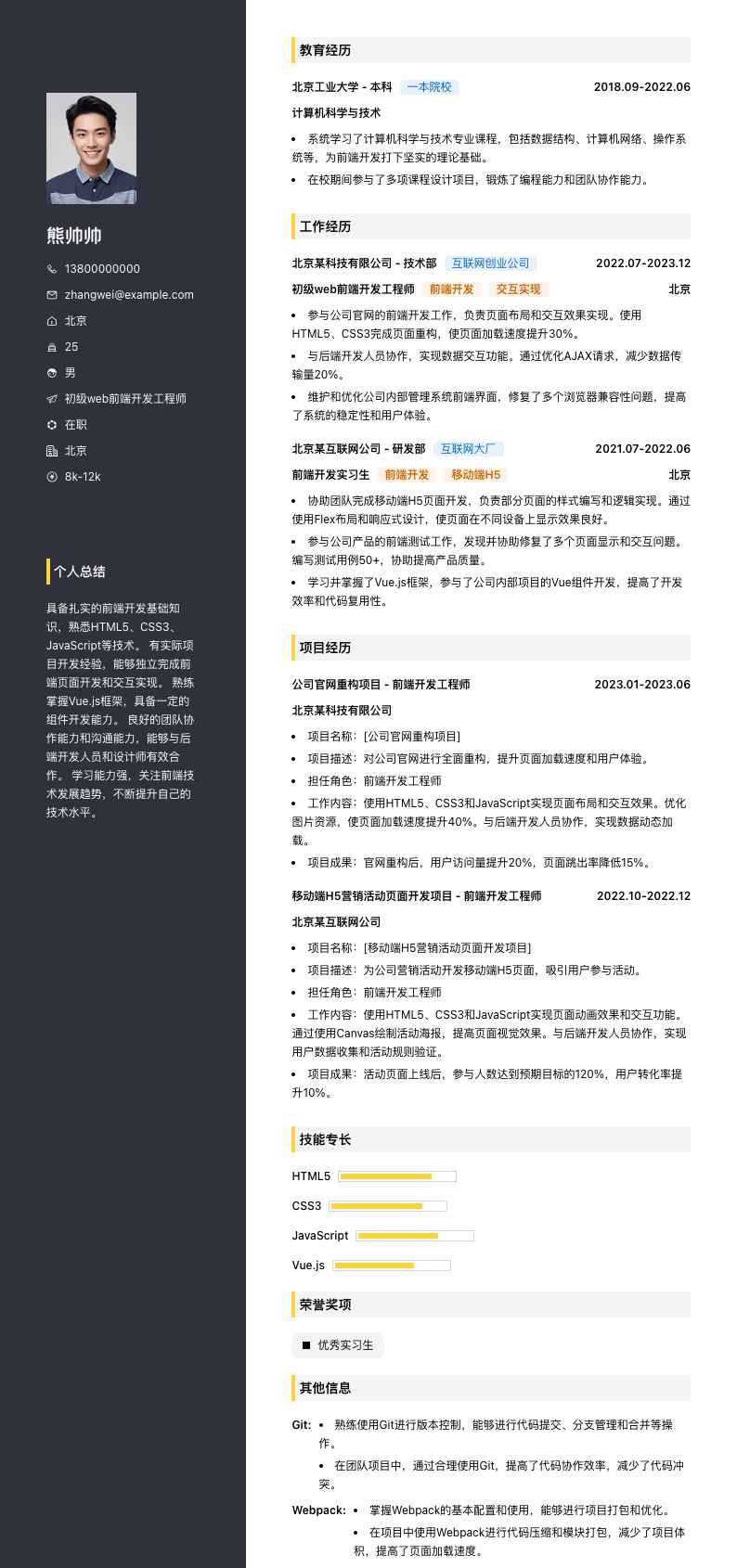

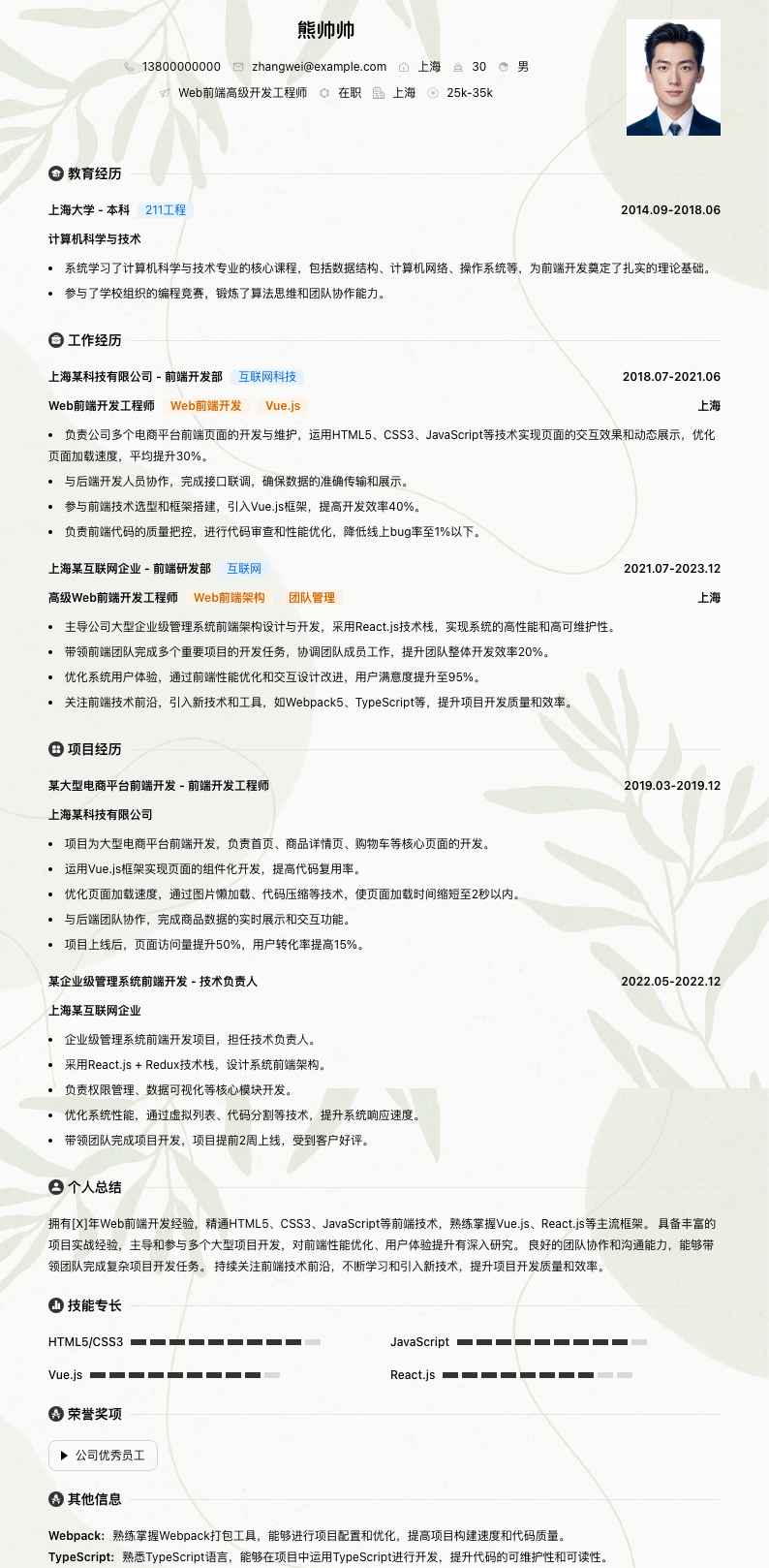

熊帅帅

教育经历

上海大学 - 本科211工程

2013.092017.06

软件工程

<li>系统学习了计算机科学与技术的基础理论和专业知识,包括数据结构、算法分析、操作系统、数据库原理等,为后续从事Hadoop实时计算工程师工作奠定了坚实的理论基础。</li><li>在校期间积极参与各类编程实践项目,锻炼了实际编码能力和团队协作能力,培养了严谨的逻辑思维和问题解决能力。</li>

工作经历

上海XX科技有限公司 - 大数据研发部互联网科技

2019.072023.06

Hadoop实时计算工程师Hadoop开发实时计算大数据平台

上海

<li>负责公司大数据平台的Hadoop实时计算模块开发与维护,参与架构设计和性能优化。通过对Hadoop集群的参数调优,使数据处理速度提升了30%,集群资源利用率提高了20%。</li><li>主导实时数据处理项目,对接业务部门需求,设计并实现了多个实时计算任务。例如,针对用户行为数据分析任务,采用Spark Streaming结合Hadoop进行实时数据清洗、转换和分析,每天处理数据量达10TB,为业务决策提供了及时准确的数据支持。</li><li>与团队成员协作,解决Hadoop实时计算过程中遇到的各种技术难题,如数据倾斜、任务调度冲突等。通过优化数据分区策略和任务调度算法,成功解决了多个复杂问题,保障了系统的稳定运行。</li><li>参与技术选型和新技术引入评估,跟踪行业最新技术动态,为公司技术发展提供建议。引入Flink进行实时计算性能对比测试,评估其在公司业务场景下的适用性,为后续技术升级提供了参考依据。</li>

上海XX信息技术有限公司 - 大数据技术部信息技术服务

2017.072019.06

大数据开发工程师大数据开发Hadoop应用实时数据处理

上海

<li>参与公司大数据平台的搭建与优化,主要负责Hadoop生态组件的集成与应用。在Hadoop集群扩容项目中,通过合理规划节点配置和数据分布,使集群存储容量提升了50%,满足了业务快速增长的数据存储需求。</li><li>负责实时数据采集与传输模块开发,使用Flume进行日志数据实时采集,Kafka进行数据缓冲和流式传输。优化Flume采集策略,减少数据丢失率至0.1%以下,保障了实时数据的完整性。</li><li>开发实时计算任务,基于Hadoop MapReduce和Spark进行离线与实时数据处理。例如,实现用户画像实时更新任务,每天处理用户行为数据5TB,更新用户标签1000+个,为精准营销提供数据支持。</li><li>进行数据质量监控与治理,建立数据质量评估体系。通过编写数据校验脚本,对实时计算结果进行质量检查,及时发现并修正数据错误,使数据准确率达到99.5%以上。</li>

项目经历

用户行为实时分析系统 - 核心开发人员

2020.012020.12

上海XX科技有限公司

<li>项目背景:随着公司业务规模扩大,用户行为数据量激增,需要实时分析用户行为,为产品优化和运营决策提供支持。</li><li>技术架构:采用Hadoop + Spark Streaming架构,Hadoop负责离线数据存储和批处理,Spark Streaming进行实时数据流式处理。</li><li>工作职责:作为核心开发人员,负责实时计算任务设计与开发。设计用户行为数据模型,定义实时计算指标(如用户活跃度、页面访问时长等)。</li><li>技术实现:使用Spark Streaming从Kafka读取用户行为日志数据,进行实时清洗(去除无效数据、格式转换)、聚合(按用户、时间窗口聚合行为数据)和分析(计算指标值)。将计算结果存储到HBase中,供业务系统实时查询。</li><li>项目成果:项目上线后,实时计算延迟从原来的分钟级降低到秒级,每天处理用户行为数据8TB,为产品优化提供了10+个关键数据指标,助力运营活动转化率提升15%。</li>

电商订单实时监控系统 - 开发负责人

2021.052021.12

上海XX科技有限公司

<li>项目背景:公司电商业务需要实时监控订单数据,及时发现异常订单(如恶意下单、高风险订单等),保障交易安全。</li><li>技术架构:基于Hadoop + Flink构建实时订单监控系统,Hadoop存储历史订单数据,Flink进行实时流式计算。</li><li>工作职责:负责实时计算逻辑设计与开发。分析业务需求,定义异常订单检测规则(如短时间内大量同一用户下单、订单金额异常波动等)。</li><li>技术实现:使用Flink从Kafka读取实时订单数据,应用定义的规则进行实时计算和判断。对检测到的异常订单,实时发送预警信息到业务系统和相关人员。</li><li>项目成果:系统上线后,实时检测异常订单准确率达95%以上,每天处理订单数据500万+条,成功拦截恶意订单100+笔,挽回经济损失数十万元,有效保障了电商交易安全。</li>

个人总结

<li>具备多年Hadoop实时计算工程师工作经验,精通Hadoop生态组件(HDFS、MapReduce、YARN等)和实时计算框架(Spark Streaming、Flink)。</li><li>熟悉大数据处理流程,能从数据采集、存储、计算到应用全链路进行设计和开发。具有丰富的项目实战经验,成功主导多个实时计算项目,取得显著业务成效。</li><li>良好的技术问题解决能力,能快速定位和解决Hadoop实时计算中遇到的性能瓶颈、数据质量等问题。具备较强的团队协作能力,善于与业务部门沟通,理解业务需求并转化为技术方案。</li><li>持续关注行业技术动态,不断学习和引入新技术,提升自身技术水平和团队整体技术实力。</li>

技能专长

Hadoop

Spark Streaming

Flink

Java

Scala

荣誉奖项

2022年度公司优秀技术员工

其他信息

数据结构与算法:

<li>熟练掌握常见数据结构(数组、链表、栈、队列、树、图等)和算法(排序算法、查找算法、动态规划等),能运用数据结构和算法优化代码性能,在Hadoop实时计算任务中,通过算法优化使部分任务执行时间缩短30%以上。</li>

数据库:

<li>熟悉关系型数据库(MySQL、Oracle)和非关系型数据库(HBase、Redis)。在实时计算项目中,负责数据库表结构设计和数据存储优化。例如,在用户行为实时分析系统中,优化HBase表设计,提高数据读写性能20%以上。</li>