ETL数据采集开发运维简历模板

熊猫简历ETL数据采集开发运维简历模板,支持自定义板块、自定义颜色、AI润色、技能条、荣誉墙、一键更换模板,专业AI辅助一键优化ETL数据采集开发运维简历内容,仅需5分钟即可拥有一份精美的ETL数据采集开发运维简历模板,助力你获得「高薪职位」。

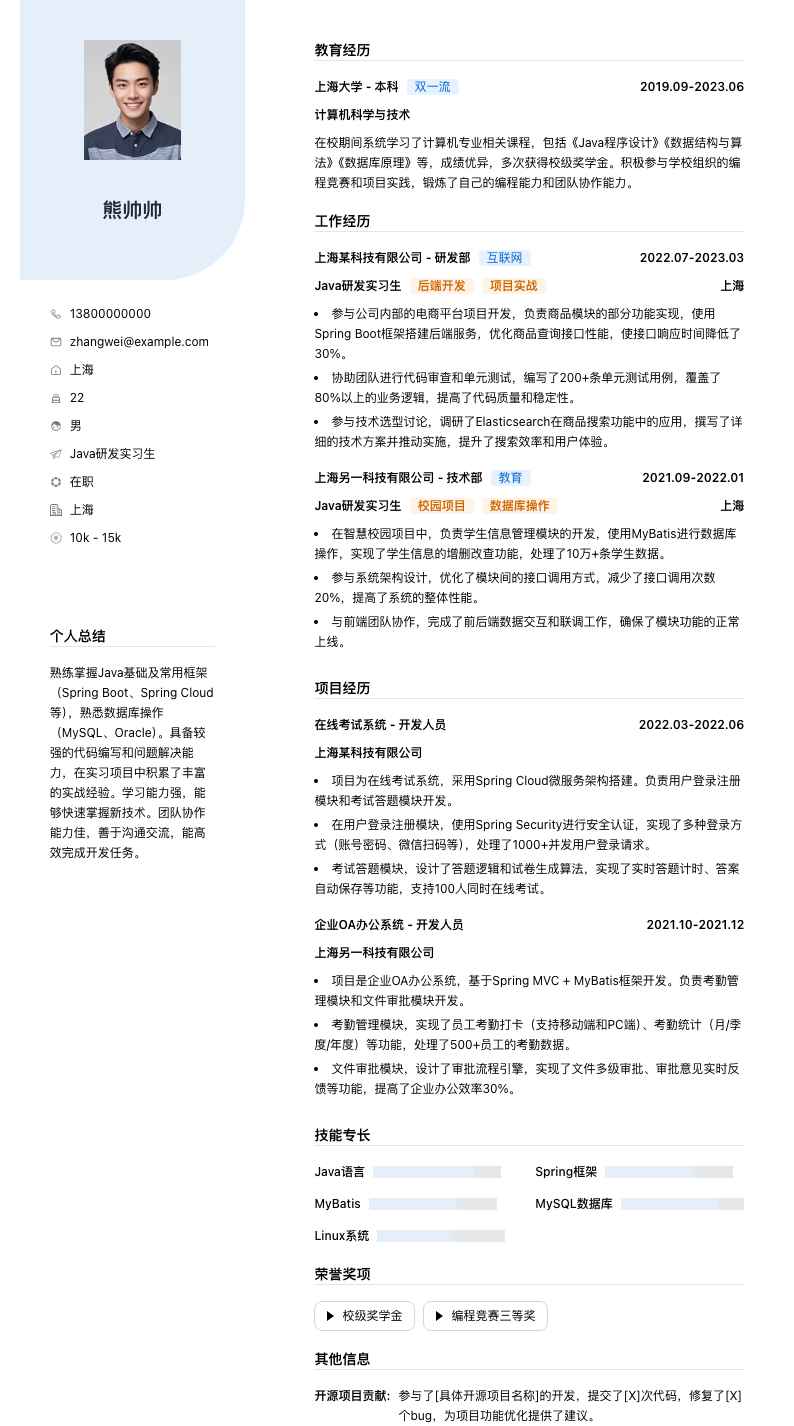

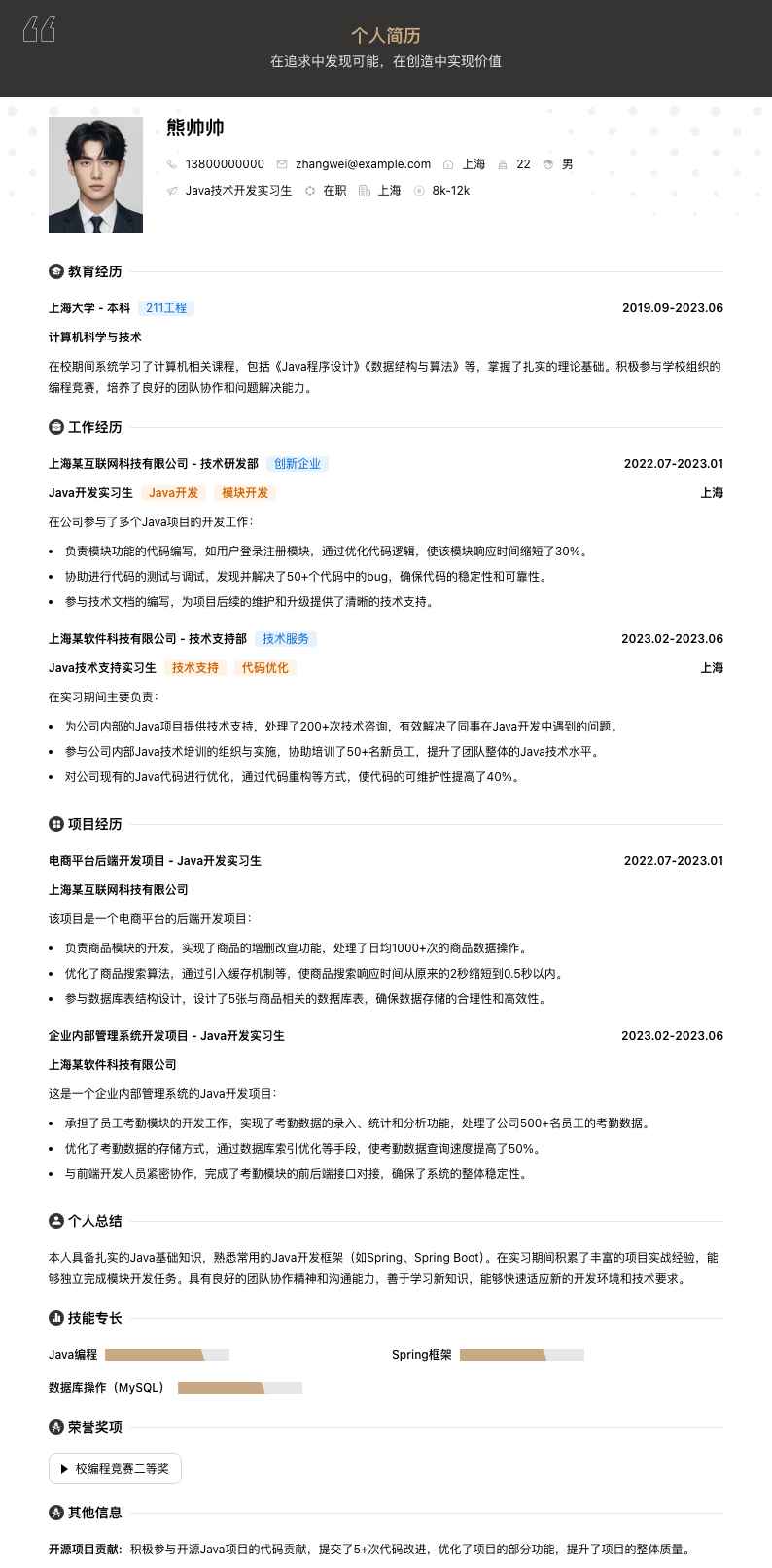

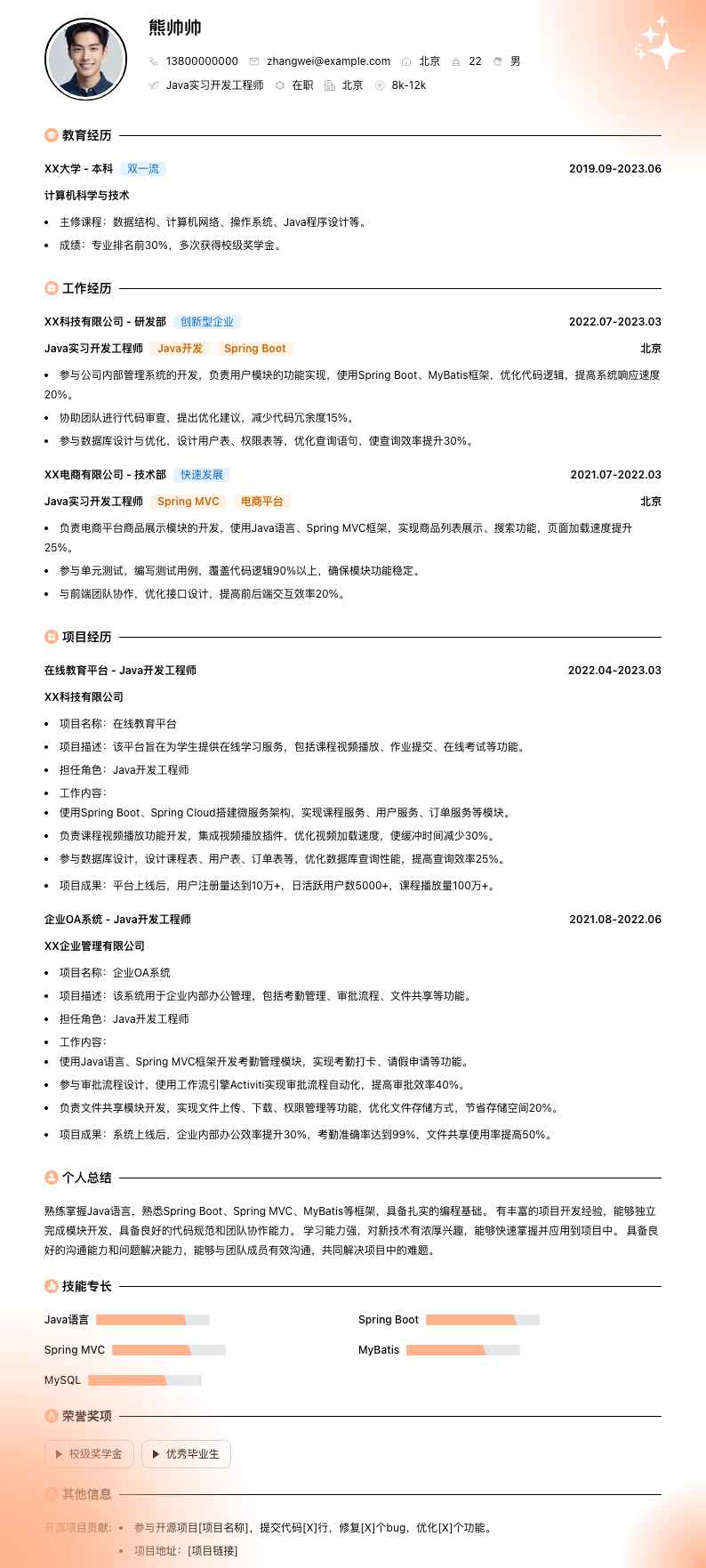

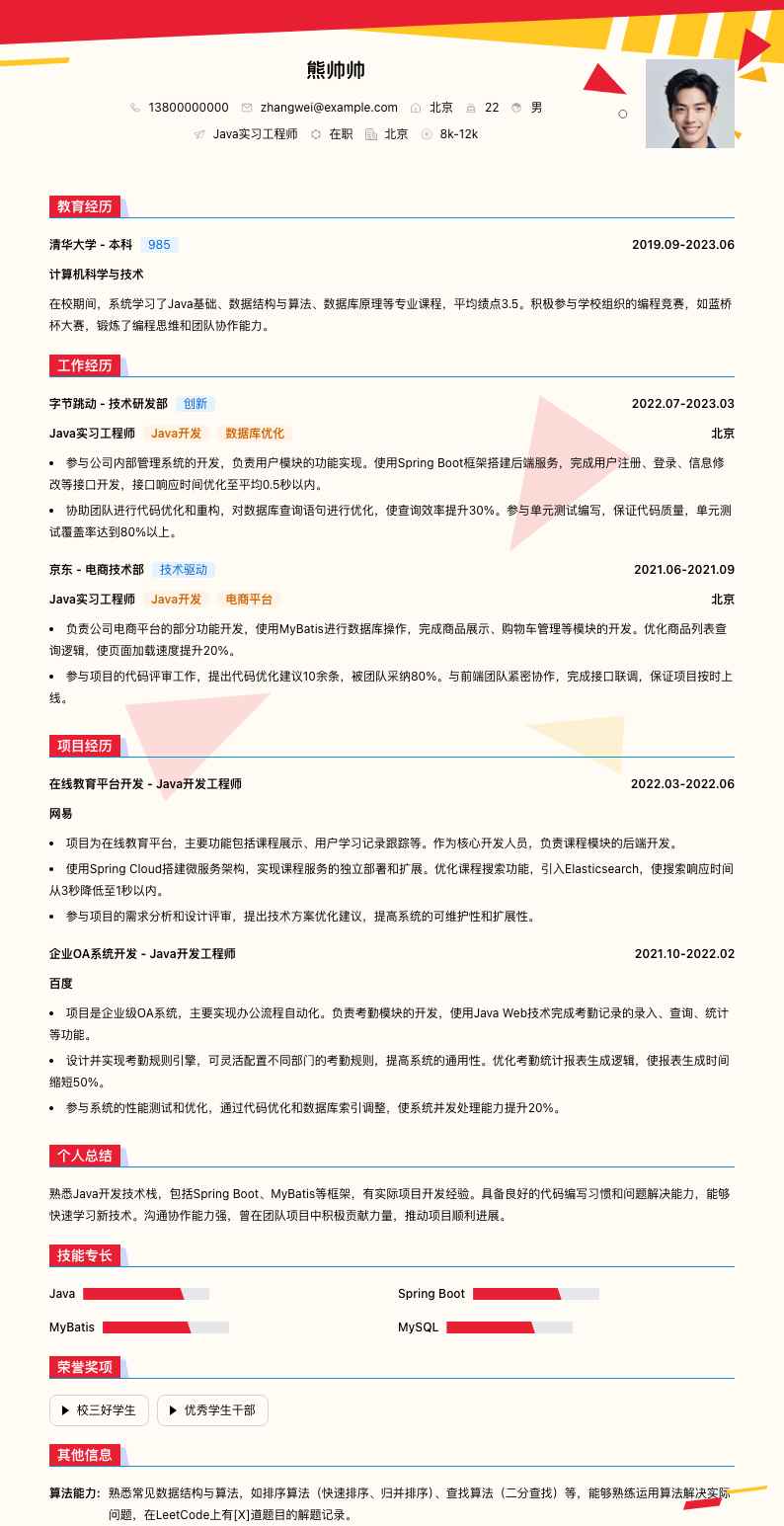

熊帅帅

• 系统学习了计算机科学与技术专业的核心课程,包括数据结构、数据库原理、操作系统等,为ETL开发运维工作奠定了扎实的理论基础。 • 参与学校组织的数据库课程设计项目,独立完成小型数据库的设计与实现,锻炼了数据库操作和问题解决能力。

• 负责公司数据仓库ETL流程的设计与开发,使用Informatica工具完成多个数据源(如Oracle、MySQL、文本文件等)的数据抽取、清洗、转换和加载工作,每月处理数据量达TB级。 • 优化现有ETL作业,通过性能调优使数据加载时间缩短30%,提高了数据仓库的数据更新时效。 • 与业务团队紧密合作,理解业务需求,设计合理的数据模型,确保数据的准确性和完整性,支持业务报表和数据分析。 • 编写详细的ETL开发文档,包括数据流程图、接口文档、测试用例等,方便团队成员理解和维护。

• 负责公司ETL系统的日常运维工作,监控ETL作业的运行状态,及时处理作业失败、数据异常等问题,保障ETL流程的稳定运行,系统可用性达到99.9%。 • 制定ETL作业的备份和恢复策略,定期进行数据备份和恢复演练,确保在数据丢失或系统故障时能快速恢复数据。 • 与开发团队协作,参与新ETL项目的上线部署工作,进行环境搭建、配置检查、上线测试等,保障项目顺利上线。 • 分析ETL系统的运行日志,提取关键指标(如作业执行时间、数据吞吐量等),生成运维报告,为系统优化提供数据支持。

• 项目背景:公司为整合多个业务系统数据,构建统一的数据仓库,需要开发一套高效稳定的ETL系统。 • 项目职责:作为核心成员参与ETL系统设计与开发,负责从多个业务数据库(Oracle、SQL Server)抽取数据,进行数据清洗(如去除重复数据、处理缺失值)、转换(如数据格式转换、业务规则计算),然后加载到数据仓库(Teradata)。 • 项目成果:成功上线ETL系统,每日处理数据量达500GB,数据加载成功率达到99.5%,为公司数据分析和决策提供了准确、及时的数据支持。

• 项目背景:因业务扩展,原有ETL系统性能不足,需要进行升级改造。 • 项目职责:主导ETL系统性能优化工作,分析系统瓶颈,对数据抽取、转换、加载过程进行优化。例如,采用并行处理技术提高数据抽取速度,优化SQL语句提升数据转换效率。 • 项目成果:优化后ETL作业运行时间缩短40%,资源利用率提高20%,满足了业务增长带来的数据处理需求。

• 拥有6年ETL数据采集开发运维经验,熟练掌握Informatica等ETL工具,具备丰富的项目实战经验。 • 擅长数据处理和性能优化,能快速定位和解决ETL系统运行中的问题,保障数据的准确性和系统的稳定性。 • 良好的沟通协作能力,与业务、开发、运维团队紧密合作,推动项目顺利实施。 • 持续学习新技术,关注行业动态,不断提升自己的专业技能,适应数据领域的快速发展。

• 熟悉星型模型、雪花模型等数据仓库建模方法,在项目中参与数据模型设计,确保数据的一致性和易用性。