ETL数据质量工程师简历模板

熊猫简历ETL数据质量工程师简历模板,支持自定义板块、自定义颜色、AI润色、技能条、荣誉墙、一键更换模板,专业AI辅助一键优化ETL数据质量工程师简历内容,仅需5分钟即可拥有一份精美的ETL数据质量工程师简历模板,助力你获得「高薪职位」。

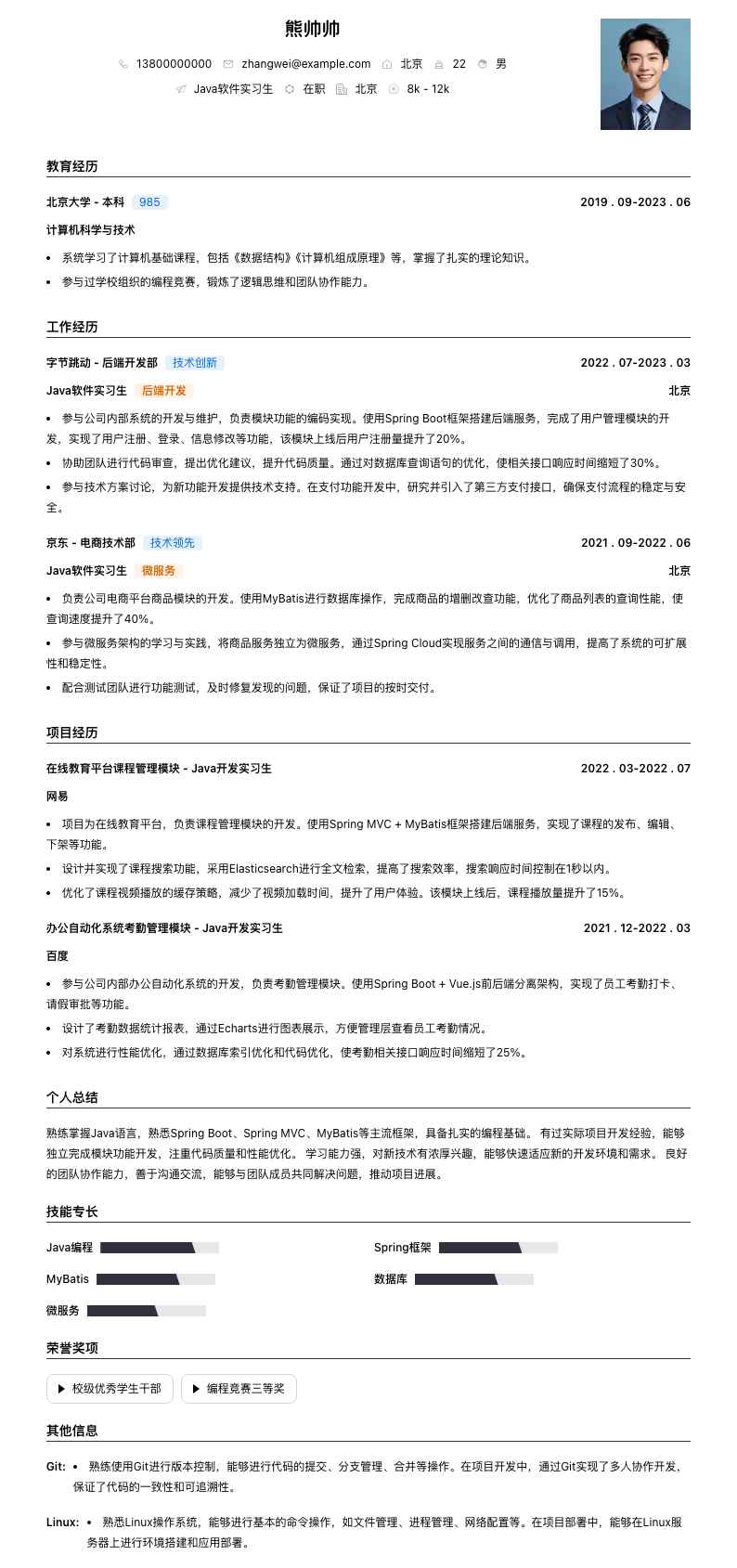

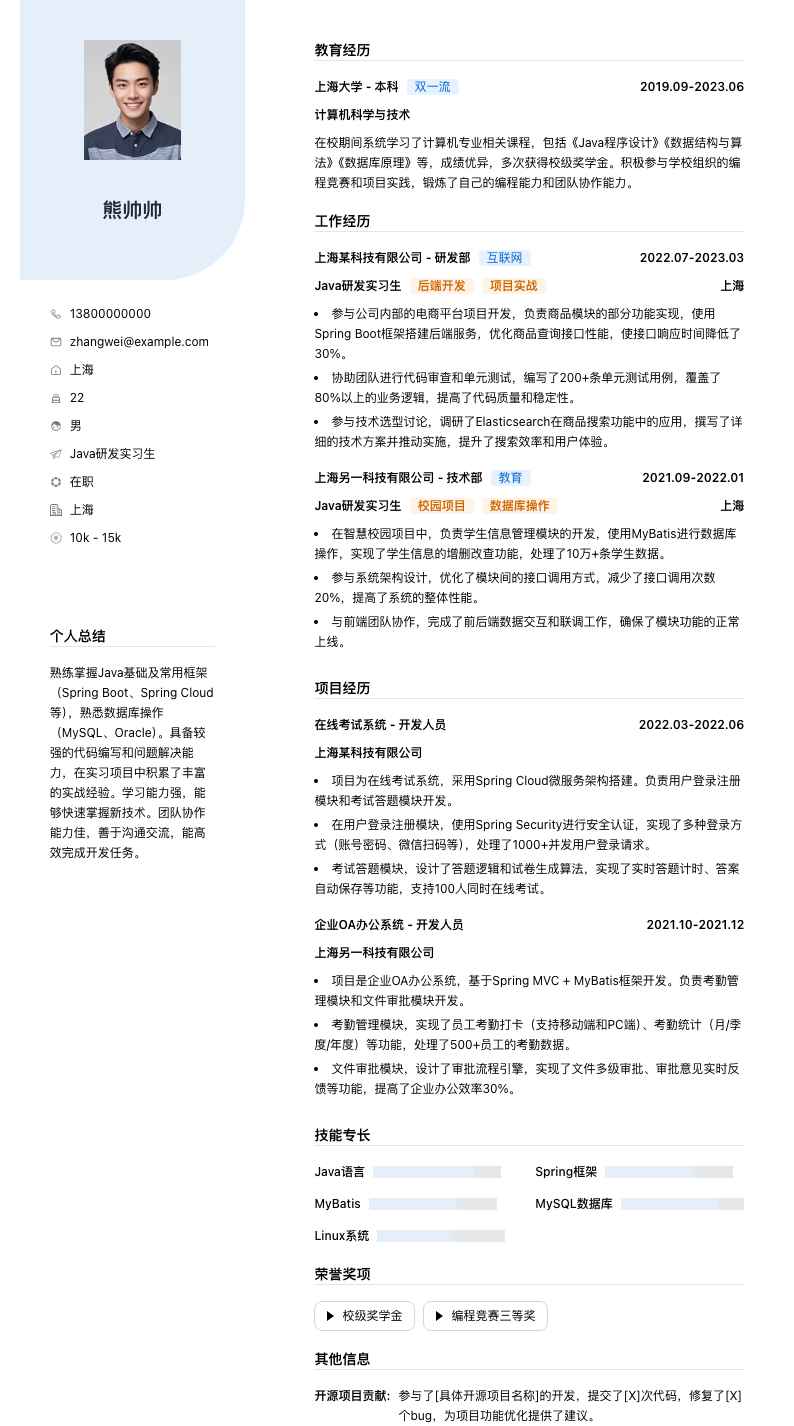

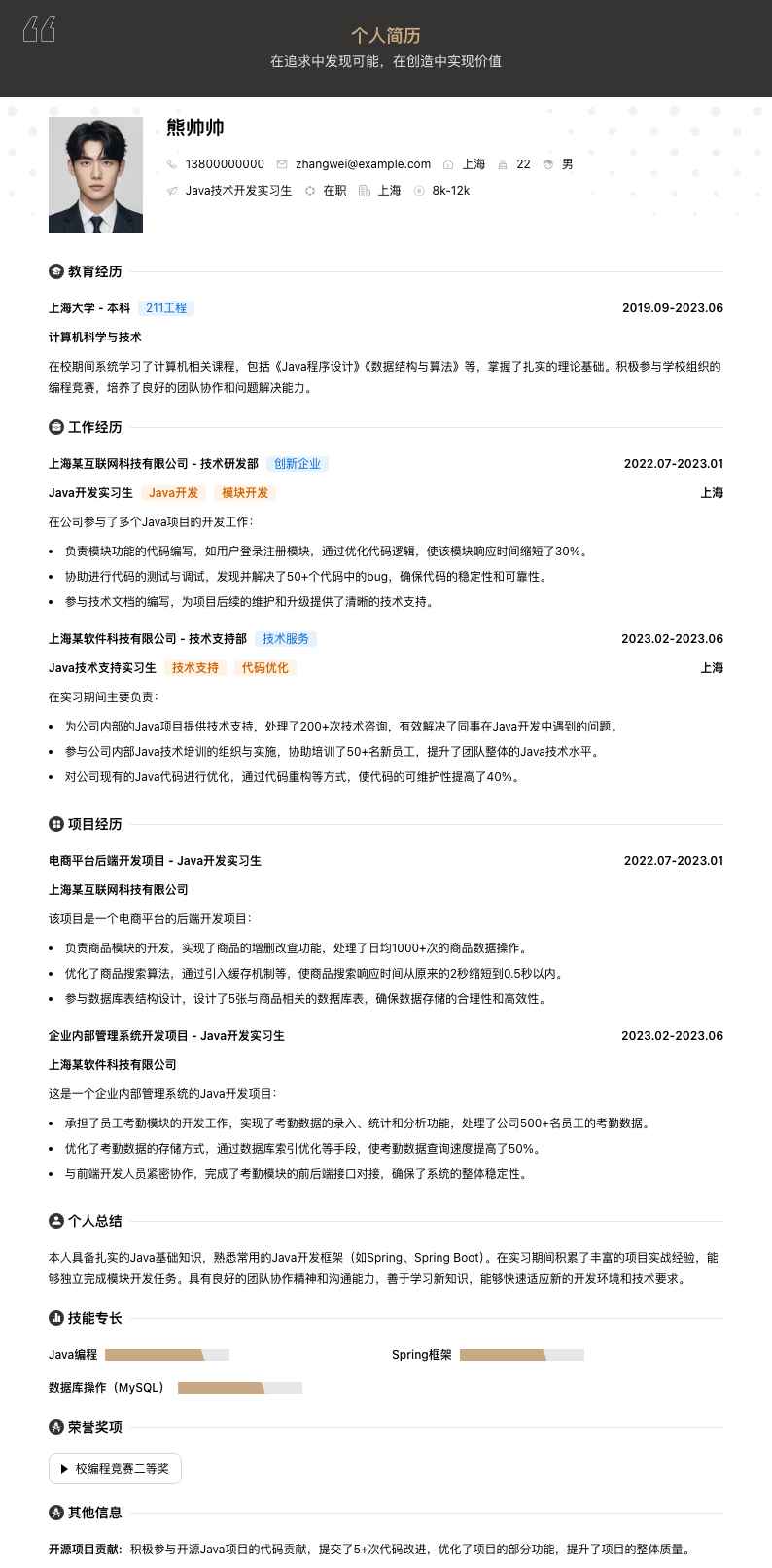

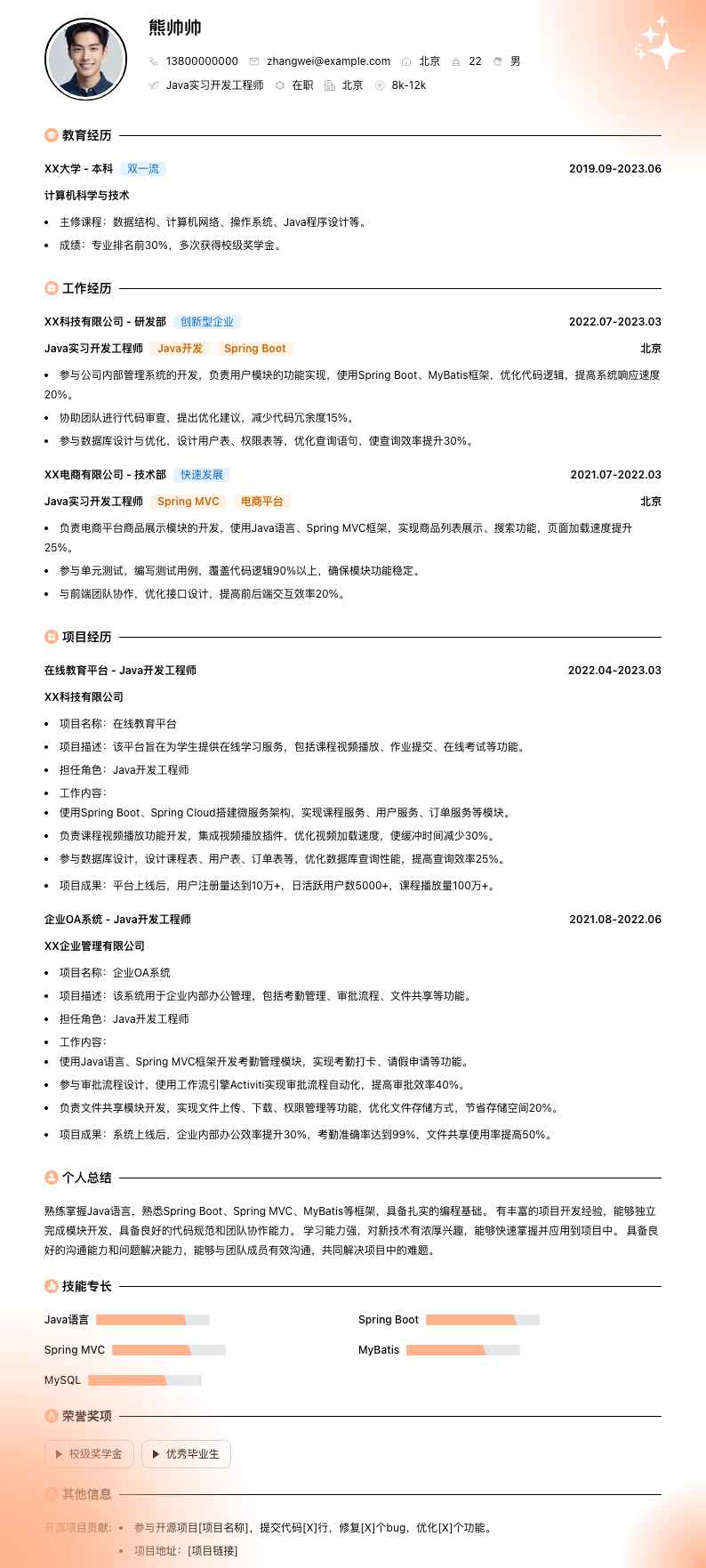

熊帅帅

个人简历• 系统学习了计算机科学与技术专业的核心课程,包括数据结构、数据库原理、算法设计与分析等,为从事数据相关工作奠定了扎实的理论基础。 • 在校期间积极参与各类编程竞赛和项目实践,锻炼了团队协作和问题解决能力。

• 负责公司核心业务系统的ETL数据质量监控,通过编写SQL脚本和使用数据质量工具,对数据抽取、转换、加载过程进行实时监测,确保数据准确性和完整性。 • 针对发现的数据质量问题,深入分析根本原因,提出优化方案并推动实施。例如,通过优化数据抽取逻辑,将某业务线数据延迟率从15%降低至5%。 • 与数据开发团队、业务部门紧密合作,参与数据需求评审,从数据质量角度提供专业建议,保障数据应用的可靠性。 • 建立数据质量指标体系,定期输出数据质量报告,为管理层决策提供数据支持。

• 主导公司数据中台项目的ETL数据质量模块建设,设计并实施数据质量校验规则,覆盖数据一致性、准确性、完整性等多个维度。 • 引入自动化数据质量检测工具,搭建数据质量监控平台,实现数据质量问题的自动预警和快速定位,将数据质量问题处理效率提升40%。 • 带领团队完成多个业务系统的数据迁移工作,制定详细的数据迁移方案和质量保障措施,确保迁移过程中数据零丢失、零错误。 • 开展数据质量培训,提升团队成员的数据质量意识和技术能力,培养了多名数据质量骨干。 • 参与行业数据质量标准制定,与同行业企业交流合作,提升公司在数据质量领域的影响力。

• 项目背景:公司业务快速扩张,原有数据质量监控体系无法满足需求,亟需升级优化。 • 项目职责:作为核心成员,负责数据质量规则梳理和优化。通过对历史数据的分析,提炼出100+条关键数据质量规则,涵盖客户信息、订单数据、交易数据等多个业务领域。 • 技术实现:使用Python编写脚本对数据进行预处理,结合SQL进行复杂的数据关联分析,利用大数据平台进行数据批量处理。引入机器学习算法,对数据质量趋势进行预测,提前发现潜在的数据质量风险。 • 项目成果:优化后的数据质量规则覆盖率提升至95%,数据质量问题发现及时率提高30%,为公司业务决策提供了更准确的数据支持。

• 项目背景:公司进行数字化转型,建设数据仓库,需要确保数据仓库中数据的高质量。 • 项目职责:全面负责数据仓库ETL过程的数据质量管控。设计数据清洗流程,对源数据中的脏数据、重复数据、缺失数据进行处理。建立数据映射关系,确保数据在抽取、转换、加载过程中的一致性。 • 技术实现:运用ETL工具(如Informatica)进行数据集成,编写存储过程实现复杂的数据转换逻辑。搭建数据质量校验平台,对数据仓库中的数据进行定期抽检和全检。 • 项目成果:数据仓库上线后,数据质量合格率达到98%,为公司数据分析和决策提供了可靠的数据基础。同时,该项目的数据质量管控经验在公司内部其他数据项目中得到推广应用。

拥有多年ETL数据质量工程师经验,精通数据质量监控、ETL优化等核心技能。具备丰富的项目实战经验,能够独立主导数据质量相关项目。善于分析数据问题,提出创新性解决方案,提升数据质量和业务价值。熟悉多种数据处理工具和技术,有良好的团队协作和沟通能力,能够推动跨部门合作解决数据质量难题。

• 深入研究行业数据质量指标体系,结合公司业务特点,构建了一套涵盖数据完整性(如字段缺失率<5%)、准确性(如数据错误率<3%)、一致性(如跨系统数据一致性达95%以上)等多个维度的指标体系。 • 通过定期对指标进行监控和分析,及时发现数据质量变化趋势,为数据治理提供方向。该指标体系在公司内部得到广泛应用,成为衡量数据质量的重要标准。